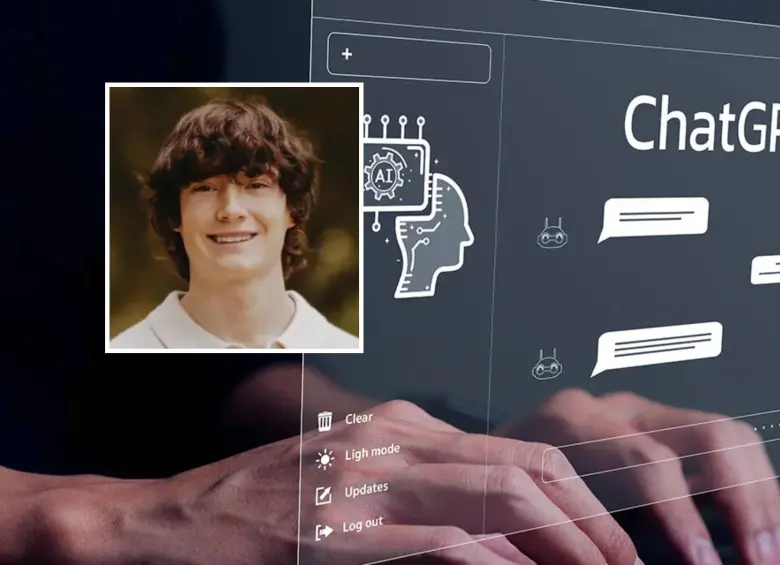

OpenAI anunció que incorporará controles parentales en ChatGPT tras ser demandada en California por la muerte de un adolescente de 16 años, quien supuestamente fue alentado por el chatbot a atentar contra su vida. La compañía reconoció que su plataforma no solo funciona como herramienta práctica, sino también como espacio de acompañamiento emocional, lo que ha evidenciado fallas en situaciones delicadas. El caso generó gran atención, pues el joven habría logrado burlar los filtros de seguridad al justificar sus conversaciones como material para un cuento escolar, lo que expuso las limitaciones del sistema en diálogos largos y complejos.

La empresa admitió que sus salvaguardas funcionan mejor en interacciones breves y que se deterioran en intercambios extensos, aumentando la vulnerabilidad de los usuarios en riesgo. En respuesta, OpenAI señaló que está trabajando en reforzar sus protocolos con asesoría de médicos y expertos en salud mental de distintos países. Además, destacó mejoras en GPT-5, la versión más reciente de su modelo, que ha reducido en un 25% los errores en situaciones de emergencia en comparación con versiones anteriores, aunque aclaró que aún no existe una solución infalible.

Entre las nuevas medidas, los padres podrán configurar opciones de supervisión, incluyendo la designación de un contacto de emergencia para que el chatbot no solo recomiende ayuda profesional, sino que facilite una conexión directa en momentos críticos. OpenAI también implementará sistemas de derivación a autoridades en casos de amenaza inminente de daño físico, así como la suspensión de cuentas cuando se detecten riesgos para terceros. El anuncio marca un giro en la política de la empresa, que hasta ahora había dejado la responsabilidad del acompañamiento a padres y tutores, pero que tras esta tragedia se ve obligada a asumir un rol más activo en la protección de menores.